|

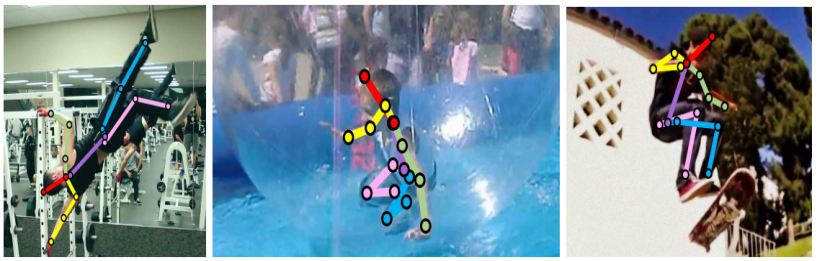

张宇教授项目组开展了基于复杂环境的行为视频理解方法研究。旨在从视频数据中对人或物体等的动态变化进行分析,是实现视频语义理解的基础及关键技术之一。针对行为视频识别的研究具有重大意义和应用价值,例如:(1)在安防领域,利用高清监控设备拍摄的视频,可以实时识别出社会公共区域中各人的行为动作,及时感知危害公共安全的行为并做相应处理(2)对各大视频网站和直播平台,可以利用计算机来进行视频内容审核,节省人力成本;(3)利用摄像头拍摄并识别人的手势动作,并依据手势来进行人机交互,这使得人机交互变得更加的便捷与人性化。其中人体的不同行为主要由不同的人体姿态产生,例如交通指挥中双臂不同的姿态可以代表不同的含义,姿态信息对于描述人体行为等至关重要,准确的人体姿态估计是行为识别任务的基础。人体姿态估计即计算人体中重要关节点(关键点)位置,如图1,有二维人体姿态估计的效果图。不同的关键点位置往往需要不同尺度范围的图像信息去推导,如头部等显式的关键点,一般只需要局部的图像信息就可以准确定位。但在复杂场景中,对于手肘等容易被遮挡而无法显式被定位的关键点,常常需要更大范围的图像信息去推导关键点位置,因而研究多尺度人体姿态估计方法是非常有必要的。本项目通过研究基于多尺度标签的关键点检测策略和基于注意力机制的多级特征融合的姿态估计方法,实现复杂场景中的多尺度人体姿态估计问题,提高复杂场景中的姿态识别准确率。

图1

|